近年、AlexaやGoogleHomeといったスマートスピーカが近年普及してきています。この普及に伴い、スマート家電などの音声を用いて家電を操作する機会が日常的に増えてきています。そのため、会話システムの質を向上する必要があると考えています。

既存製品の会話システムは、音声を音声認識により文字に変換し、変換した文字情報から話者の伝えたい内容を推定しています。

しかし実際の人間同士の会話では、情報を得る際に文字情報以外の非言語情報を多く用いて会話をしています。

今日のスマートスピーカを人間同士で行うような会話に近づけるには、文字情報に加え、口調やボディーランゲージなどが必要になっていくと考えられます。

本研究ではこの口調に含まれる情報として「尺度」を推定します。本研究において「尺度」とは「何をどのくらいしたかったのか」という「度合い」を指します。本研究のシステムにより口調から話者の伝えたい「尺度」を推定できるようにします。そのため、今後のスマートスピーカなどの会話システムで、より人間の会話に近づけるようになると考えています。

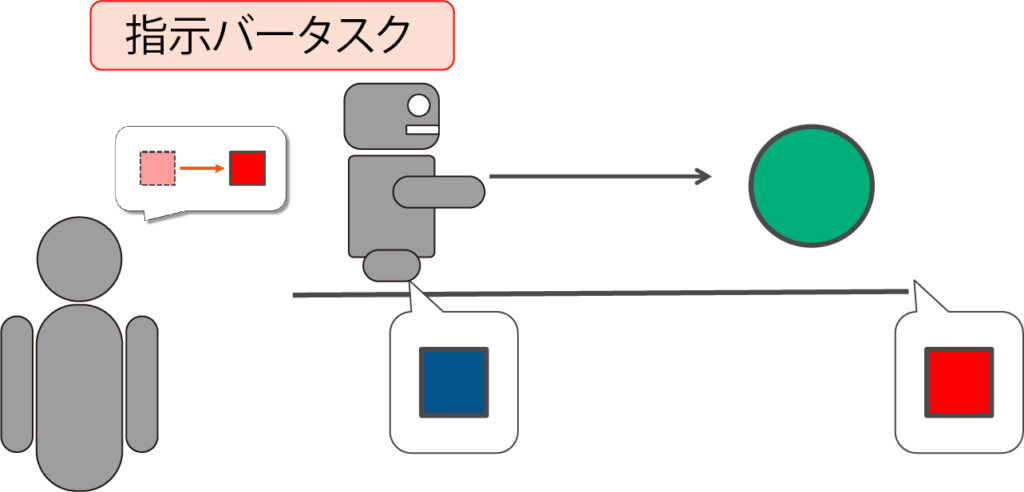

「尺度」を推定を行うために本研究では機械学習の一つである Long Short Term Memory (LSTM) を用いて話者の推定を行いました。そしてこの手法のパフォーマンスを確かめるために、指示バータスクを提案しました。この指示バータスクは、話者が「もうちょっと」と発声することによってバーの移動量を推定し、実際の指示した移動量と比較をして評価をします。結果として本手法は精度が低い問題があげられますが、バータスクにおける操作バーの移動量を推定できることが確認できました。